Kluczowe informacje:

- Litery są reprezentowane w systemie binarnym jako liczby zgodnie z kodem ASCII.

- Każda litera odpowiada unikalnej wartości dziesiętnej, która jest konwertowana na kod binarny.

- Odczytując ciąg binarny, należy podzielić go na grupy po 8 bitów (bajty).

- Unicode to bardziej zaawansowany standard kodowania, który obsługuje znaki z różnych alfabetów.

- Komputery nie rozróżniają typów danych, co jest określane przez programy i systemy operacyjne.

Jak odczytać litery w systemie binarnym i ich konwersja

Aby zrozumieć, jak odczytać litery w systemie binarnym, ważne jest, aby wiedzieć, że komputery reprezentują znaki, takie jak litery, jako liczby. Te liczby są następnie zapisywane w formie binarnej, co oznacza, że składają się z cyfr 0 i 1. W kontekście komputerowym, najbardziej powszechnie stosowanym standardem do przypisywania tych liczb do znaków jest ASCII (American Standard Code for Information Interchange), który przypisuje unikalne wartości każdemu znakowi.

Na przykład, litera 'A' ma wartość 65, a 'a' to 97 w systemie dziesiętnym. Każda litera jest zatem reprezentowana w systemie binarnym jako ciąg 8 bitów, co oznacza, że każda litera zajmuje jeden bajt pamięci. Właściwe zrozumienie tego procesu jest kluczowe, aby móc efektywnie pracować z danymi w formacie binarnym, co jest istotne w programowaniu i przetwarzaniu informacji.

Zrozumienie, jak działa system binarny w kontekście liter

System binarny składa się z dwóch cyfr: 0 i 1. Każdy bit w tym systemie reprezentuje potęgę liczby 2, co oznacza, że kombinacje tych bitów mogą tworzyć różne wartości. Na przykład, ciąg binarny 01100001 odpowiada literze 'a' w systemie ASCII, ponieważ jego wartość dziesiętna wynosi 97.

W kontekście liter i znaków, każda litera jest konwertowana na odpowiednią wartość binarną, co pozwala komputerom na ich przetwarzanie. Zrozumienie tej konwersji jest kluczowe, gdyż umożliwia odczyt i interpretację danych w formacie binarnym. Bez znajomości tych podstawowych zasad, trudniej jest zrozumieć, jak działają programy komputerowe oraz jak zarządzać danymi w różnych formatach.

Jak przekształcić litery na kod binarny krok po kroku

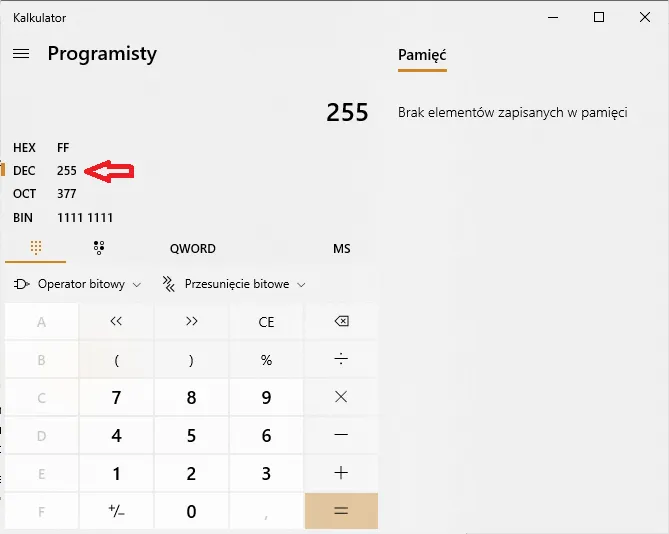

Aby przekształcić litery na kod binarny, należy najpierw zrozumieć, jak działają wartości ASCII. Każda litera, cyfra lub znak specjalny ma przypisaną unikalną wartość dziesiętną w tabeli ASCII. Na przykład, litera 'A' ma wartość 65, a 'B' to 66. Kluczowym krokiem w konwersji jest odnalezienie tej wartości, co stanowi fundament dalszych działań.

Następnie, po znalezieniu wartości dziesiętnej, przekształcamy ją na system binarny. Każda liczba dziesiętna jest reprezentowana w systemie binarnym jako ciąg 0 i 1. Na przykład, wartość dziesiętna 65 odpowiada binarnemu ciągowi 01000001. Warto pamiętać, że każda litera jest reprezentowana przez 8 bitów, co oznacza, że każda konwersja powinna prowadzić do 8-cyfrowego wyniku.

Przykład konwersji liter na kod binarny

W celu lepszego zrozumienia procesu konwersji, warto przyjrzeć się kilku konkretnym przykładom. Oto tabela, która przedstawia kilka popularnych liter, ich wartości ASCII oraz odpowiadające im reprezentacje binarne:

| Litera | Wartość ASCII | Reprezentacja binarna |

| A | 65 | 01000001 |

| B | 66 | 01000010 |

| C | 67 | 01000011 |

| a | 97 | 01100001 |

| b | 98 | 01100010 |

Czytaj więcej: Jak dzielić system binarny: proste kroki i przykłady, które pomogą

Wartość dziesiętna liter w tabeli ASCII i ich binarne odpowiedniki

Tabela ASCII (American Standard Code for Information Interchange) przypisuje unikalne wartości dziesiętne literom, cyfrom i znakom specjalnym, co jest kluczowe dla zrozumienia, jak komputer interpretuje tekst. Każda litera w alfabecie ma przypisaną wartość, która jest następnie konwertowana na system binarny. Na przykład, litera 'A' ma wartość 65, a 'B' to 66. Te wartości są niezbędne do przetwarzania danych w formie binarnej, co jest podstawą działania komputerów.

Wartości dziesiętne są następnie przekształcane na ich odpowiedniki binarne, co umożliwia komputerom przechowywanie i przetwarzanie informacji. Na przykład, wartość 65, odpowiadająca literze 'A', jest reprezentowana w systemie binarnym jako 01000001. Zrozumienie tego procesu jest kluczowe, aby móc efektywnie pracować z danymi w formacie binarnym i zrozumieć, jak komputery operują na tekstach.

Przykłady konwersji liter na wartości ASCII i binarne

Przykłady konwersji liter na wartości ASCII i ich odpowiedniki binarne mogą pomóc w lepszym zrozumieniu tego procesu. Oto lista kilku popularnych liter oraz ich wartości dziesiętne i binarne:

| Litera | Wartość ASCII | Reprezentacja binarna |

| A | 65 | 01000001 |

| B | 66 | 01000010 |

| C | 67 | 01000011 |

| D | 68 | 01000100 |

| E | 69 | 01000101 |

Jak odczytać ciąg binarny i przetłumaczyć go na tekst

Aby odczytać ciąg binarny, należy najpierw podzielić go na grupy po 8 bitów, co odpowiada jednemu bajtowi. Każda grupa 8 bitów reprezentuje jedną literę lub znak w systemie ASCII. Na przykład, ciąg binarny 01101000 01100101 01101100 01101100 01101111 można podzielić na pięć bajtów, które odpowiadają literom 'h', 'e', 'l', 'l' i 'o'. Odczytując te grupy, możemy z łatwością przetłumaczyć je na tekst.

Po podzieleniu ciągu binarnego na bajty, każdy bajt należy przekonwertować na wartość dziesiętną, aby znaleźć odpowiadający mu znak w tabeli ASCII. Na przykład, bajt 01101000 ma wartość dziesiętną 104, co odpowiada literze 'h'. W ten sposób, przekształcając wszystkie bajty, możemy odtworzyć oryginalny tekst. Proces ten jest kluczowy dla interpretacji danych w formacie binarnym.

Wprowadzenie do bardziej zaawansowanych systemów kodowania

Podczas gdy ASCII jest powszechnie stosowane do reprezentacji podstawowych znaków, Unicode oferuje znacznie szerszy zakres możliwości. Unicode jest standardem kodowania, który obsługuje znaki z różnych alfabetów i języków, co czyni go bardziej uniwersalnym rozwiązaniem. Dzięki Unicode, możemy reprezentować tysiące znaków, w tym znaki z alfabetów takich jak cyrylica czy ideogramy chińskie.

Jednak ASCII ma swoje ograniczenia, ponieważ nie obsługuje znaków spoza podstawowego zestawu 128 znaków. Wprowadzenie Unicode umożliwiło programistom i użytkownikom łatwiejsze zarządzanie tekstem w różnych językach oraz zapewnienie, że teksty będą prawidłowo wyświetlane na różnych platformach. Dzięki temu, Unicode stał się standardem w nowoczesnych systemach komputerowych.

Co to jest Unicode i jak różni się od ASCII

Unicode to standard kodowania, który został zaprojektowany w celu reprezentacji tekstu w praktycznie wszystkich językach świata. W przeciwieństwie do ASCII, który obsługuje jedynie 128 podstawowych znaków, Unicode może reprezentować ponad 143,000 znaków. Obejmuje to litery, cyfry, znaki interpunkcyjne oraz znaki specjalne z różnych kultur i języków, co czyni go znacznie bardziej wszechstronnym rozwiązaniem.

Unicode zapewnia spójność w reprezentacji tekstu, co jest kluczowe w globalizowanym świecie. Dzięki temu, że Unicode obsługuje wiele języków i systemów pisma, programiści mogą tworzyć aplikacje, które są dostępne dla użytkowników na całym świecie. To sprawia, że Unicode jest niezbędnym narzędziem w nowoczesnym przetwarzaniu tekstu i komunikacji cyfrowej.Jakie są inne standardy kodowania znaków i ich zastosowania

Poza ASCII i Unicode istnieje wiele innych standardów kodowania znaków, które są używane w różnych kontekstach. Na przykład, ISO-8859 to rodzina standardów kodowania, która obsługuje różne zestawy znaków dla różnych języków europejskich. Umożliwia to łatwe zarządzanie tekstem w językach takich jak niemiecki, francuski czy hiszpański, które wymagają znaków diakrytycznych.

Innym przykładem jest UTF-8, który jest jedną z najpopularniejszych form Unicode. UTF-8 jest elastycznym systemem kodowania, który pozwala na reprezentację wszystkich znaków Unicode, a jednocześnie jest zgodny z ASCII dla standardowych znaków. Dzięki temu, UTF-8 jest szeroko stosowany w aplikacjach internetowych, co zapewnia, że teksty będą poprawnie wyświetlane w różnych przeglądarkach i systemach operacyjnych.

Praktyczne zastosowania Unicode w nowoczesnym programowaniu

W erze globalizacji i różnorodności kulturowej, Unicode odgrywa kluczową rolę w tworzeniu aplikacji, które są dostępne dla szerokiego grona użytkowników. Programiści mogą wykorzystać Unicode do tworzenia interfejsów użytkownika obsługujących wiele języków, co znacząco zwiększa zasięg ich produktów. Na przykład, aplikacje mobilne mogą automatycznie dostosowywać teksty do preferencji językowych użytkowników, co poprawia doświadczenia i zwiększa zaangażowanie.

Dodatkowo, w kontekście przetwarzania danych, Unicode umożliwia efektywne zarządzanie i analizowanie tekstów w różnych językach. Wykorzystując techniki takie jak analiza sentymentu czy przetwarzanie języka naturalnego (NLP), programiści mogą tworzyć algorytmy, które rozumieją kontekst i znaczenie tekstu w wielu językach. To otwiera drzwi do innowacyjnych rozwiązań w obszarze sztucznej inteligencji, umożliwiając tworzenie bardziej zaawansowanych i intuicyjnych systemów, które lepiej odpowiadają na potrzeby użytkowników na całym świecie.